A saúde na era da (des)inteligência artificial

Foto: Freepik/IA

Foto: Freepik/IA

A inteligência artificial (IA) está avançando a galope também – e talvez especialmente – na área da saúde. Aliás, melhor seria dizer que estamos sob uma verdadeira avalanche de novas ferramentas, algoritmos, robôs e várias outras formas de manifestação da IA médica que, graças às promessas de reduzir o esforço humano e de aumentar os lucros da indústria da saúde, estão sendo incorporadas a uma velocidade espantosa aos processos médicos em áreas tão diversas como a pesquisa clínica e a prestação do cuidado propriamente dita.

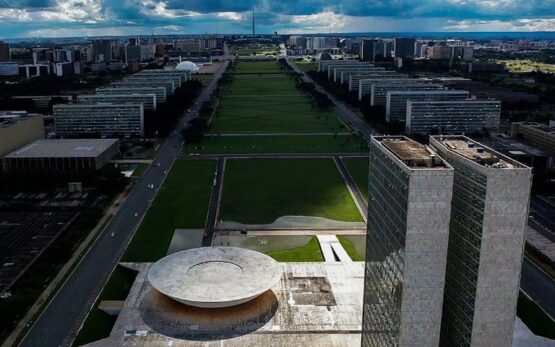

Recentemente, o Senado brasileiro aprovou um marco regulatório que servirá de base para que se exerça algum controle sobre o desenvolvimento de novas ferramentas de IA nas diversas áreas. Para alguns, o marco teria sido muito complacente ao deixar de fora alguns dos algoritmos mais problemáticos da atualidade – e que seguramente têm impacto significativo na saúde da população –, como os algoritmos usados pelas famigeradas redes sociais. Por outro lado, é bastante positivo que a saúde tenha sido incluída entre as áreas consideradas de “alto risco”, que são aquelas áreas onde a regulamentação deve ser exercida de forma mais intensiva e cuidadosa.

Há várias razões para que a área da saúde represente uma área de alto risco para o uso da IA. Uma delas é a questão dos erros relacionados aos cuidados de saúde (os famigerados “erros médicos”). Quando um profissional individualmente se engana ou comete um erro, ele pode causar dano apenas àquela pessoa que recebe seus cuidados no momento. Por outro lado, quando uma ferramenta de IA que toma ou auxilia na tomada de decisões importantes comete um erro ou atua de maneira tendenciosa, ela pode causar dano a milhares de pessoas antes mesmo que o erro seja detectado. Tal forma de erro médico em larga escala poderia até mesmo ganhar o neologismo de “IA-trogenia” para representar o dano em larga escala causado pela IA médica.

Outra razão para necessitarmos de um tanto de parcimônia na adoção de novas tecnologias de IA médica é que elas acabam por mudar – não necessariamente para melhor – a forma como os profissionais atuam. Partindo da ideia de Marshall McLuhan de que o meio é a mensagem, fica fácil perceber que criamos tecnologias que estão longe de serem neutras e que acabam por moldar nosso trabalho. Ao delegarmos à IA diversas funções hoje executadas pelos médicos, é provável que, com o passar do tempo, os profissionais percam habilidades que são cruciais para exercerem sua atividade, o que apenas aumentará nossa dependência da IA.

Existe ainda uma visão ingênua de que a IA facilitará o trabalho médico e permitirá que os profissionais dediquem mais tempo aos pacientes. A ingenuidade dessa visão está no fato de que, apesar de todas as tecnologias anteriores (como os prontuários eletrônicos e as formas de comunicação remota entre profissionais e pacientes) terem prometido algo semelhante, a triste realidade é que os profissionais dedicam cada vez menos tempo ao cuidado do paciente no consultório ou à beira de um leito de hospital.

Ainda se poderia citar inúmeras outras ameaças representadas pela adoção apressada e ampla das tecnologias de IA na medicina. Uma delas é a opacidade dos algoritmos, os quais não podem ser facilmente auditados por estarem protegidos por sigilo comercial. Outra ameaça é representada pelos poderosos interesses econômicos existentes em cada nova ferramenta cuja adoção pela medicina pode representar um lucro bilionário para as empresas e seus acionistas. Embora exista quem minimize o problema e afirme que tudo isso é secundário, considerando-se os eventuais benefícios para a saúde das pessoas, nem todo mundo pensa dessa forma.

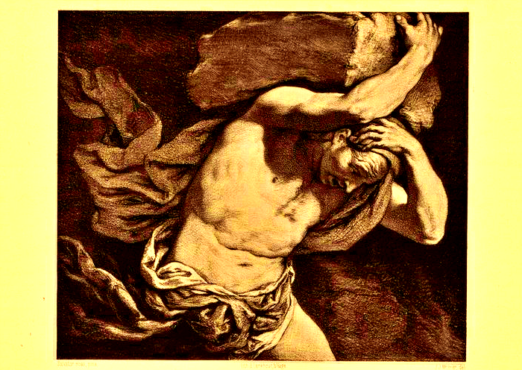

Em seu mais recente livro Nexus, Yuval Harari alerta para os riscos da IA generativa atual e de seu uso amplo em diversas áreas da sociedade, chegando a afirmar que deveríamos ter em relação à IA o mesmo grau de cuidado que a sociedade teve em relação a outras tecnologias potencialmente destrutivas, como a energia nuclear. Quem considere exagerada essa comparação deve lembrar que no início do século 20 a energia nuclear foi intensamente explorada comercialmente sem qualquer controle efetivo. Assim, antes que descobríssemos os perigos do contato direto entre os seres humanos e a energia nuclear, várias empresas comercializaram produtos contendo radiação ionizante, incluindo sabonetes, pastas de dente e até mesmo famigerados supositórios radioativos.

Com o passar do tempo, descobrimos com a triste experiência que a radiação ionizante era causa importante de doenças graves em seres humanos e que muita gente havia sido prejudicada pela nova tecnologia. Porém, considerando o fato de que a comunidade científica reconhecia alguns usos benéficos da energia nuclear, ela não foi abandonada pelo homem. Em vez disso, tivemos cautela e passamos a controlar rigorosamente o uso dessa fonte de energia, conseguindo proteger a população ao mesmo tempo em que passávamos a usar a energia nuclear para atividades benéficas como a produção de energia em usinas nucleares e a radioterapia para tratamento de vários tipos de câncer.

Talvez a IA devesse ser usada de maneira parecida com a energia nuclear, em aplicações pontuais e sem envolver uma ampla interação direta com os seres humanos. Já foi demonstrado que a IA pode prejudicar as pessoas comuns, como quando algoritmos estúpidos instigam adolescentes ao suicídio ou a cometer outros atos de violência. Já parece também claro que o uso inadequado da IA por estudantes pode prejudicar seu desenvolvimento acadêmico.

A IA não é intrinsecamente boa nem ruim, pois isso depende basicamente do uso que faremos dela. A pressa na adoção da tecnologia interessa apenas àqueles que lucrarão com a sua ampla e rápida adoção pela sociedade. Há quem insista na pressa com base na ideia de que não podemos perder o trem da modernidade, mas tal imperativo fica difícil de sustentar se lembrarmos que vivíamos muito bem sem a IA até 2023, quando ela ficou disponível comercialmente. Além disso, está claro que esperarmos algum tempo até que os efeitos potencialmente benéficos ou prejudiciais da IA em curto e longo prazo sejam conhecidos é uma manifestação de sabedoria que só poderia fazer bem à sociedade.

Ao referir-se ao mundo digital em uma entrevista recente, Pepe Mujica afirma que o Homo sapiens atual não estaria à altura das tecnologias que inventa. Segundo ele, temos avançado muito em termos tecnológicos, mas quase nada em termos de valores humanistas. A sabedoria de Mujica pode até parecer simples, mas é de uma profundidade e relevância impressionantes para o Homo neoliberalis moderno.

André Islabão é médico, integrante do movimento Slow Medicine Brasil e autor dos livros Slow Medicine – Sem pressa para cuidar bem, O risco de cair é voar e Entre a estatística e a medicina da alma – Ensaios não controlados do Dr. Pirro.